Aktuell machen Schlagzeilen und Blogartikel die Runde, in denen behauptet wird, dass Apple ab macOS 13.1 Bilder scannt, die im Finder angezeigt werden. Es wird behauptet, dass es sich dabei um den CSAM-Scan handle, der nach Child Sexual Abuse Material suche.

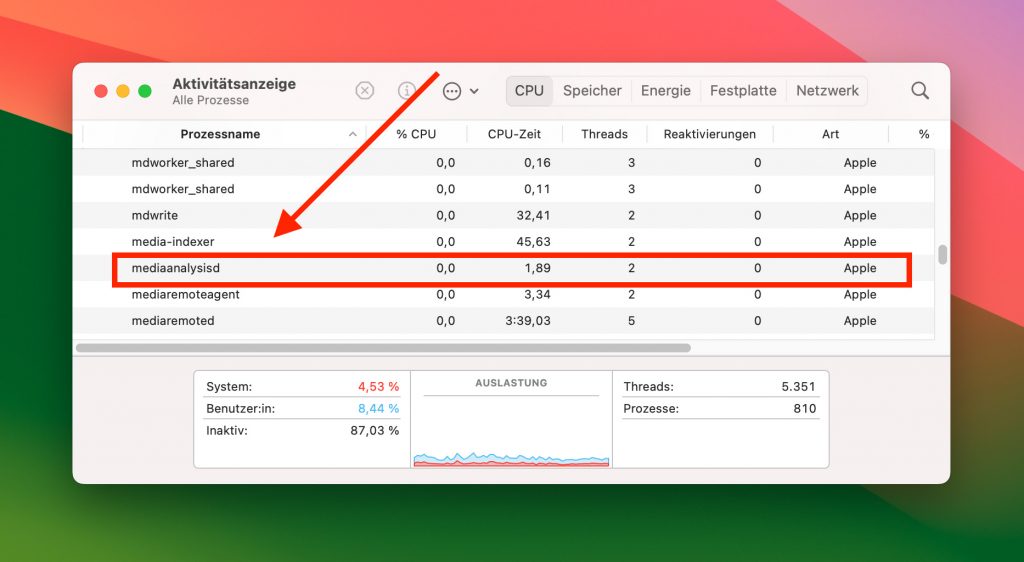

Obwohl oder gerade weil Apple im letzten Jahr deutlich gemacht hat, unter iOS, in der iCloud, auf dem Mac und auch andernorts nicht nach Bildern und Videos zu suchen, die den sexuellen Missbrauch von Kindern zeigen, wird das Thema wieder aufgegriffen. Auslöser ist der Datenaustausch mit Apple-Servern über den mediaanalysisd Prozess von macOS. Doch dieser hat damit gar nichts zu tun.

Verwirrung um CSAM-Scan und den mediaanalysisd Prozess unter macOS 13.1

Die Diskussion kam auf, weil auf einigen Macs beobachtet wurde, dass mediaanalysisd eine Verbindung zu einem Apple-Server aufgebaut hat bzw. aufbauen wollte. Ein Blogartikel nennt als Werkzeug zur Erkennung der Netzwerkverbindung die Little Snitch App. Diese kann als Firewall genutzt werden, sodass Netzwerkanfragen eingesehen sowie zugelassen oder abgeblockt werden können.

Durch die im letzten Jahr häufigen Schlagzeilen und Artikel zum CSAM-Scan und der potenziellen Erkennung von Nacktbildern auf den Endgeräten wurden einige User aufgrund von mediaanalysisd wieder hellhörig und ließen sich zur vorschnellen Annahme verleiten, dass der CSAM-Scan nun doch durchgesetzt wurde.

Die Medienanalyse hat nichts mit der Nacktbild-Erkennung zu tun

Interessant ist dabei zu beobachten, dass diese Verbindung ohne technische Herleitung hergestellt wird. Es geht der Äußerung, dass mediaanalysisd und CSAM-Scan miteinander in Verbindung stünden, kein tieferer Blick in die Materie voraus. Das allein ist schon ein Indiz dafür, dass da etwas nicht stimmt.

Denn jene Artikel und Berichte, die eine Analyse des Prozess-Codes und des Netzwerkaustauschs enthalten, kommen zu dem Schluss, dass es sich bei der Medienanalyse um den schon seit Jahren angewendeten Prozess handelt, der für die Personen-, Tier- und Objekterkennung sowie für das „Live Text“-Feature zur Texterkennung in Bildern benötigt wird. Und diese nutzt keine unverschlüsselten Bildinhalte, sondern Hash-Codes.

Quelle: The Electic Light Company

Warum wird ein jahrealter macOS-Prozess jetzt auf einmal diskutiert?

Dass es mediaanalysisd schon recht lange gibt, ist schnell recherchiert. Es finden sich Diskussionen dazu in Apples User-Foren sowie im Developer Forum (hier und hier). Einige der Threads auf den Seiten sind bereits sieben Jahre alt.

Die Diskussion dazu startete nun aber mit größerer Beachtung, da Server-Anfragen des Prozesses nach dem Update auf macOS Ventura 13.1 scheinbar auch dann über die Internet-Verbindung rausgehen, wenn Bilder über den Finder bzw. per QuickLook-Funktion angeschaut werden – also abseits von Vorschau oder der Fotos App.

Dass es sich hierbei um einen Bug handeln könnte, weil quasi keine relevanten Daten ausgetauscht werden, wird in diesem Twitter-Thread aufgezeigt.

Fazit zum Thema

Nein, Apple hat mit mediaanalysisd nicht heimlich einen Nacktbild-Scanner auf dem Mac installiert. Die Medienanalyse ist seit Jahren ein Bestandteil von Apple-Systemen, von dem User auch täglich profitieren. Sei es durch die Personen-Suche in der Fotos App, durch die Texterkennung in aktuellen Betriebssystemen, durch die Möglichkeit, Bildinhalte wie Pflanzen, Tiere und Kunst in Online-Lexika nachzuschlagen oder dergleichen mehr.

Eine kurze Recherche und die Lektüre von technischen Analysen des Prozesses zeigen, dass dafür auch nur verschlüsselte Codes und keine reinen Bildinhalte oder gar Kopien übermittelt werden. Die Privatsphäre bleibt erhalten und Ermittlungsbehörden wird keine unnötige Hintertür zur Überwachung geschaffen. Es wurden also nur zwei zeitnahe Dinge in Verbindung gebracht, die keine echte Verbindung haben.